Capítulo 1: Introdução aos Estudos Quasi-Experimentais no Contínuo da Pesquisa

1.1 Definição e Princípio Central: A Ausência de Randomização

No universo da pesquisa científica, a busca por relações de causa e efeito é um objetivo primordial. Os estudos quasi-experimentais representam uma classe de delineamentos de pesquisa empírica cujo propósito é estimar o impacto causal de uma intervenção sobre um desfecho de interesse, mas que se distinguem por uma característica fundamental: a ausência de atribuição aleatória (random assignment) dos participantes aos grupos de estudo.1 Em um experimento verdadeiro, ou ensaio clínico randomizado (ECR), o pesquisador utiliza um processo probabilístico (como o sorteio) para alocar os sujeitos a um grupo que receberá a intervenção (grupo experimental) ou a um grupo que não a receberá (grupo de controle). Esse procedimento garante, em teoria, que os grupos sejam equivalentes em todas as características, tanto observáveis quanto não observáveis, exceto pela exposição à intervenção. A randomização é, portanto, a pedra angular que permite a inferência causal com alto grau de confiança.3

Os delineamentos quasi-experimentais, por outro lado, operam em cenários onde essa alocação aleatória não ocorre.4 Em vez disso, os grupos de comparação são formados com base em critérios não aleatórios. Os participantes podem ser alocados a grupos que já existem naturalmente (como turmas de uma escola, pacientes de diferentes hospitais ou cidadãos de diferentes municípios), podem se auto-selecionar para participar de um programa, ou podem ser designados com base em regras administrativas ou limiares de elegibilidade.6 O termo “quasi-experimento”, popularizado por Campbell e Stanley em sua obra seminal de 1963, reflete precisamente essa natureza: a pesquisa se assemelha a um experimento por envolver a manipulação de uma variável independente (a intervenção), mas carece do controle total proporcionado pela randomização, tornando-a “quase” um experimento.5

A ausência de randomização é, portanto, o princípio definidor que gera tanto os desafios quanto as oportunidades dos estudos quasi-experimentais. A tarefa central do pesquisador que adota essa metodologia é construir um argumento robusto e convincente de que, apesar da alocação não aleatória, as diferenças observadas no desfecho podem ser atribuídas de forma plausível à intervenção, e não a outras explicações alternativas ou vieses.5

1.2 O Posicionamento dos Delineamentos Quasi-Experimentais: Uma Ponte entre o Experimento e a Observação

Para compreender plenamente o papel dos estudos quasi-experimentais, é útil visualizá-los em um contínuo de metodologias de pesquisa, posicionados estrategicamente entre os estudos observacionais e os experimentos verdadeiros.7 Em um extremo do espectro, encontram-se os estudos puramente observacionais (como estudos de coorte ou caso-controle), nos quais o pesquisador não interfere, limitando-se a observar e analisar as associações entre exposições e desfechos que ocorrem naturalmente na população.9 No extremo oposto, estão os ensaios clínicos randomizados, que representam o padrão-ouro para a inferência causal devido ao máximo controle exercido pelo pesquisador sobre a alocação da intervenção.3

Os estudos quasi-experimentais ocupam um espaço intermediário nesse contínuo.10 Eles compartilham com os experimentos a presença de uma intervenção deliberada, ou seja, o pesquisador está ativamente avaliando o efeito de uma política, programa ou tratamento. Contudo, compartilham com os estudos observacionais a ausência de controle sobre a alocação dos participantes, que é determinada por forças externas ao controle do pesquisador.5 Essa posição híbrida confere aos quasi-experimentos um caráter único. Eles são mais robustos para a inferência causal do que os estudos observacionais, pois a intervenção e a medição dos desfechos são, em geral, planejadas prospectivamente. No entanto, são mais vulneráveis a vieses do que os ECRs, exigindo um arcabouço teórico e analítico sofisticado para fortalecer as conclusões.7

A escolha por um delineamento quasi-experimental não deve ser interpretada como uma alternativa “inferior” a um ECR, mas sim como a metodologia de primeira linha e mais apropriada para uma classe específica de perguntas de pesquisa. A questão fundamental não é qual delineamento é abstratamente superior, mas qual responde de forma mais válida e viável à pergunta de interesse, dadas as complexidades e restrições do mundo real. Para avaliar o impacto de leis, políticas macroeconômicas ou desastres naturais, a randomização é conceitualmente impossível. Nesses domínios, os delineamentos quasi-experimentais não são uma segunda opção, mas sim o padrão metodológico mais rigoroso disponível.12

1.3 A Busca pela Inferência Causal em Cenários do Mundo Real: Por que e Quando Utilizar um Quasi-Experimento?

A principal razão de ser dos estudos quasi-experimentais reside na sua aplicabilidade a cenários do “mundo real”, onde a pesquisa experimental clássica encontra barreiras intransponíveis.13 A randomização, embora ideal do ponto de vista metodológico, é frequentemente inviável por razões logísticas, éticas ou políticas.12

Considere a avaliação de políticas públicas: seria eticamente indefensável e politicamente inviável sortear aleatoriamente quais cidades receberão um novo programa de saneamento básico ou quais cidadãos estarão sujeitos a uma nova lei de trânsito. Da mesma forma, em educação, pode não ser possível alocar aleatoriamente alunos a diferentes métodos de ensino se isso implicar negar a um grupo o acesso ao currículo padrão.6 Em saúde pública, durante uma pandemia, não seria ético randomizar o acesso a uma vacina comprovadamente eficaz. Nesses e em muitos outros contextos, os estudos quasi-experimentais emergem como a ferramenta mais poderosa e, por vezes, a única viável para se aproximar de uma inferência causal.12

O objetivo central de um estudo quasi-experimental é, portanto, estimar o efeito causal de uma variável independente (a intervenção) sobre uma variável dependente (o desfecho), através da criação de um cenário contrafactual plausível. O contrafactual representa o que teria acontecido com o grupo que recebeu a intervenção se, contrafactualmente, ele não a tivesse recebido. Como esse cenário não pode ser observado diretamente, os delineamentos quasi-experimentais utilizam grupos de comparação ou observações ao longo do tempo para construí-lo e, assim, isolar o impacto da intervenção.12

Tabela 1: Comparativo entre Delineamentos de Pesquisa: Experimental, Quasi-Experimental e Observacional

| Característica | Estudo Experimental (ECR) | Estudo Quasi-Experimental | Estudo Observacional |

| Atribuição dos participantes | Randomizada (aleatória) | Não-randomizada (determinística, por conveniência, etc.) | Não aplicável (exposição ocorre naturalmente) |

| Manipulação da variável de exposição | Presente (controlada pelo pesquisador) | Presente (controlada pelo pesquisador ou por evento externo) | Ausente (pesquisador apenas observa) |

| Grupo de comparação | Sempre presente e equivalente por desenho | Frequentemente presente, mas não equivalente por desenho | Presente (ex: grupo não-exposto), mas não equivalente |

| Principal desafio metodológico | Validade externa (generalização para o mundo real) | Validade interna (controle de vieses de seleção e confusão) | Validade interna (controle de múltiplos vieses) |

| Nível de evidência para causalidade | Alto | Moderado a alto (dependendo do rigor do delineamento) | Baixo a moderado |

Capítulo 2: Validade e Vieses: Os Desafios Centrais da Inferência Causal

2.1 Validade Interna: O Grau de Confiança na Relação Causa-Efeito

A validade interna é o conceito mais crítico na avaliação de um estudo quasi-experimental. Ela se refere ao grau de confiança com que se pode afirmar que a relação observada entre uma intervenção (variável independente) e um desfecho (variável dependente) é verdadeiramente causal, e não o resultado de fatores alternativos ou de confusão.7 Em termos simples, um estudo com alta validade interna responde afirmativamente à pergunta: “Foi a intervenção, e não outra coisa, que causou a mudança observada no desfecho?”.16

Nos ensaios clínicos randomizados, a validade interna é largamente garantida pelo próprio ato da randomização, que distribui equitativamente todos os potenciais fatores de confusão entre os grupos. Em um estudo quasi-experimental, a ausência dessa salvaguarda coloca a responsabilidade diretamente sobre o pesquisador. Ele deve, através do delineamento do estudo e da análise estatística, construir um caso lógico e empírico robusto para a causalidade, identificando e descartando sistematicamente as “hipóteses rivais” ou “ameaças à validade interna” que poderiam explicar os resultados.5

As ameaças à validade interna são fatores que oferecem explicações alternativas plausíveis para os achados de uma pesquisa. As ameaças clássicas, sistematizadas por Campbell e colaboradores, incluem 15:

- História: Refere-se a eventos externos específicos que ocorrem entre a medição pré-teste e pós-teste, simultaneamente à intervenção, e que podem afetar o desfecho. Por exemplo, se durante a avaliação de um programa anti-tabagismo em uma cidade, o governo nacional aprova um aumento súbito nos impostos sobre cigarros, a redução observada no fumo pode ser devida à intervenção, ao aumento de preço, ou a ambos.

- Maturação: Corresponde a processos que ocorrem naturalmente nos participantes ao longo do tempo, como envelhecimento, crescimento, fadiga ou melhora espontânea. Uma intervenção para melhorar as habilidades de leitura em crianças ao longo de um ano letivo precisa demonstrar um efeito que vá além da maturação cognitiva natural esperada para aquela idade.

- Testagem: Ocorre quando o ato de realizar um pré-teste influencia os resultados do pós-teste. Os participantes podem aprender com o teste, lembrar-se das respostas ou se tornarem mais sensíveis ao tema, alterando seu comportamento independentemente da intervenção.

- Instrumentação: Refere-se a mudanças no instrumento de medição, nos observadores ou nos procedimentos de coleta de dados entre o pré-teste e o pós-teste. Se um equipamento de medição se descalibra ou se os entrevistadores se tornam mais experientes (e, portanto, mais eficientes) ao longo do estudo, as mudanças no desfecho podem refletir essa variação instrumental, e não o efeito da intervenção.

- Regressão à Média: É um fenômeno estatístico no qual participantes selecionados com base em escores extremos (muito altos ou muito baixos) em uma medição tendem a apresentar escores mais próximos da média em uma medição subsequente, puramente devido à variação aleatória. Se um programa de reforço escolar seleciona apenas os alunos com as piores notas, parte da melhora observada no pós-teste pode ser simplesmente regressão à média, e não um efeito real do programa.

- Seleção: Esta é a ameaça mais proeminente e universal nos estudos quasi-experimentais. Ocorre quando existem diferenças sistemáticas pré-existentes entre os grupos de tratamento e controle que estão relacionadas ao desfecho. Se os participantes de um programa de bem-estar são voluntários, eles podem já ser mais motivados, saudáveis e proativos do que os não-participantes, e essas características, e não o programa, podem explicar melhores resultados de saúde.5

- Mortalidade (Atrito): Refere-se à perda diferencial de participantes dos grupos de estudo ao longo do tempo. Se, por exemplo, os participantes menos motivados do grupo de tratamento abandonam o estudo em uma taxa maior do que os do grupo de controle, o efeito aparente da intervenção no final do estudo será superestimado, pois será baseado apenas nos participantes mais motivados que permaneceram.

2.2 Validade Externa: A Generalização dos Resultados

Enquanto a validade interna se preocupa com a correção da inferência causal dentro do estudo, a validade externa aborda a questão da generalização: até que ponto os resultados e as conclusões do estudo podem ser aplicados a outras populações, outros contextos e outros tempos?.16

Curiosamente, o que constitui a principal fraqueza dos estudos quasi-experimentais em termos de validade interna (a falta de controle e randomização) muitas vezes se torna sua maior força em termos de validade externa.5 Experimentos de laboratório ou ECRs altamente controlados, embora internamente válidos, podem criar condições tão artificiais que seus resultados não se replicam no “mundo real”, que é mais complexo e heterogêneo.

Os estudos quasi-experimentais, por serem frequentemente conduzidos em ambientes naturalísticos e com populações que interagem com as intervenções de forma realista (incluindo a auto-seleção), tendem a ter uma validade externa mais elevada. Eles avaliam o efeito de tratamentos em segmentos da população que são mais propensos a escolher ou a serem escolhidos para esses tratamentos, fornecendo uma estimativa mais pragmática do impacto do programa quando implementado em escala.5

2.3 O Equilíbrio Crítico: O Trade-off entre Validade Interna e Externa

A pesquisa metodológica frequentemente descreve um “dilema do pesquisador” ou um trade-off inerente entre validade interna e externa. Medidas que aumentam o controle e a certeza causal (como a seleção de participantes muito homogêneos ou a condução do estudo em um ambiente de laboratório) tendem a limitar a generalização dos resultados. Por outro lado, conduzir um estudo em um ambiente naturalístico com uma população diversa aumenta a validade externa, mas introduz uma miríade de fatores de confusão que ameaçam a validade interna.16

A excelência na pesquisa quasi-experimental não reside em eliminar completamente esse trade-off, mas em gerenciá-lo de forma consciente e transparente. Uma abordagem poderosa para isso é o “multiplismo crítico”, que defende o uso de uma combinação de métodos, onde os pontos fortes de um compensam as fraquezas do outro.18 Mais importante, as ameaças à validade interna não devem ser vistas apenas como uma lista de verificação de problemas a serem lamentados, mas sim como um roteiro proativo para o desenho do estudo. Os delineamentos quasi-experimentais mais sofisticados, que serão explorados nos capítulos seguintes, foram desenvolvidos precisamente como soluções estruturais para neutralizar essas ameaças. Por exemplo, a ameaça da seleção motiva o uso de um pré-teste e de técnicas como o pareamento, enquanto a ameaça da história motiva a adição de um grupo de controle a um delineamento de série temporal. Assim, um bom pesquisador não apenas reconhece as ameaças, mas projeta seu estudo para enfrentá-las diretamente.

Tabela 2: Principais Ameaças à Validade Interna e Estratégias de Mitigação

| Ameaça | Definição | Exemplo em Saúde Pública | Estratégia de Mitigação no Delineamento/Análise |

| História | Evento externo que ocorre simultaneamente à intervenção e afeta o desfecho. | Uma campanha local de incentivo à atividade física coincide com uma olimpíada nacional, aumentando o interesse geral por esportes. | Adicionar um grupo de controle não exposto à intervenção, mas exposto ao evento histórico (Delineamento de Séries Temporais com Grupo Controle). |

| Maturação | Mudanças naturais nos participantes ao longo do tempo. | Pacientes com depressão leve podem apresentar melhora espontânea ao longo de seis meses, independentemente de uma nova terapia. | Incluir um grupo de controle que não recebe a terapia para medir a taxa de melhora espontânea. |

| Seleção | Diferenças sistemáticas pré-existentes entre os grupos de tratamento e controle. | Pessoas que se inscrevem voluntariamente em um programa de perda de peso já são mais motivadas do que a população geral. | Medir características basais (pré-teste) para avaliar a não-equivalência; usar Pareamento por Escore de Propensão (PSM) para criar grupos estatisticamente comparáveis. |

| Regressão à Média | Tendência de escores extremos se aproximarem da média em medições repetidas. | Um programa de controle de hipertensão focado apenas em pacientes com as leituras de pressão arterial mais altas observará uma redução, parte da qual é puramente estatística. | Incluir um grupo de controle com escores igualmente extremos que não recebe a intervenção para estimar o efeito da regressão. |

| Instrumentação | Mudanças no processo de medição ao longo do tempo. | Os entrevistadores se tornam mais eficientes na aplicação de um questionário de qualidade de vida após as primeiras semanas do estudo. | Treinamento rigoroso e contínuo dos aplicadores; usar instrumentos padronizados e calibrados; cegamento dos avaliadores, se possível. |

| Testagem | O pré-teste influencia os resultados do pós-teste. | Responder a um questionário sobre conhecimento de práticas de sexo seguro (pré-teste) pode levar os participantes a pesquisarem o assunto, melhorando seu conhecimento no pós-teste. | Omitir o pré-teste (delineamento mais fraco) ou usar o Delineamento de Quatro Grupos de Solomon (raro na prática); usar medidas não-reativas. |

| Mortalidade (Atrito) | Perda diferencial de participantes entre os grupos. | Em um ensaio de um novo medicamento com efeitos colaterais, os pacientes que se sentem pior no grupo de tratamento podem abandonar o estudo em maior proporção. | Realizar análises de intenção de tratar (intention-to-treat); analisar as características dos participantes que abandonaram para verificar se há diferenças sistemáticas. |

Capítulo 3: Delineamentos Clássicos de Grupos de Comparação

3.1 O Delineamento com Grupo de Controle Não Equivalente (GCNE)

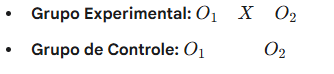

O Delineamento com Grupo de Controle Não Equivalente (GCNE) é talvez o mais fundamental e amplamente utilizado dos desenhos quasi-experimentais.19 Sua popularidade deriva de sua estrutura intuitiva, que se assemelha a um experimento verdadeiro, mas adaptada para situações onde a randomização não é possível. A estrutura básica envolve dois grupos: um que recebe a intervenção (grupo experimental) e outro que não (grupo de controle). A característica definidora é que esses grupos não são formados por alocação aleatória e, portanto, não se pode presumir que sejam equivalentes no início do estudo.20

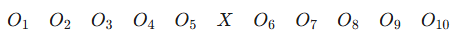

A versão mais robusta e recomendada deste delineamento é aquela que inclui medições antes (pré-teste) e depois (pós-teste) da intervenção para ambos os grupos. A notação formal para este desenho é:

Onde O1 representa a observação ou medição do desfecho no pré-teste, X representa a exposição à intervenção, e O2 representa a observação no pós-teste.

O papel do pré-teste (O1 ) é absolutamente crucial para a validade deste delineamento.21 Ele cumpre duas funções essenciais. Primeiro, permite ao pesquisador documentar e quantificar a extensão da não-equivalência inicial entre os grupos. Ao comparar os escores de O1 entre o grupo experimental e o de controle, pode-se avaliar o quão diferentes eles eram antes mesmo da intervenção começar. Segundo, e mais importante, os dados do pré-teste fornecem uma linha de base que pode ser usada na análise estatística para ajustar as diferenças iniciais, fortalecendo a inferência causal. Em vez de simplesmente comparar os resultados do pós-teste ( O1 vs. O2 ), a análise se concentra em comparar a magnitude da mudança do pré para o pós-teste entre os dois grupos.

A lógica subjacente é que, se a intervenção teve um efeito, o grupo experimental deveria mostrar uma mudança de O1 para O2 que é significativamente diferente da mudança observada no grupo de controle durante o mesmo período. Este foco na mudança ao longo do tempo ajuda a controlar algumas ameaças à validade interna, como a maturação e a história (assumindo que ambos os grupos foram expostos a eventos históricos semelhantes). O delineamento GCNE com pré-teste não “resolve” magicamente o viés de seleção, mas o transforma de um problema desconhecido e incontrolável em um fator mensurável e estatisticamente ajustável. É uma mudança fundamental da ignorância para o gerenciamento da incerteza, e é essa lógica que conecta este delineamento a técnicas analíticas mais avançadas, como a análise de Diferença-em-Diferenças (Capítulo 6).

Existem variações deste delineamento, como a versão que utiliza apenas o pós-teste. No entanto, este desenho é consideravelmente mais fraco, pois na ausência de um pré-teste, não há como saber se as diferenças observadas no pós-teste já existiam antes da intervenção. Qualquer conclusão causal de um delineamento apenas com pós-teste e grupos não equivalentes é altamente especulativa. A principal limitação que persiste mesmo na versão com pré-teste é a ameaça de interações entre seleção e outras ameaças, como a seleção-maturação. Isso ocorreria se os grupos não apenas diferissem no início, mas também tivessem taxas de mudança natural diferentes ao longo do tempo, um viés que o pré-teste sozinho não consegue resolver.

Capítulo 4: Delineamentos de Séries Temporais Interrompidas (STI)

4.1 A Lógica da Interrupção: Analisando Mudanças em Nível e Tendência

O Delineamento de Séries Temporais Interrompidas (STI), ou Interrupted Time Series (ITS), é uma abordagem quasi-experimental particularmente poderosa e cada vez mais utilizada para avaliar o impacto de intervenções de larga escala, como políticas públicas ou programas de saúde populacionais, que são implementadas em um ponto específico e bem definido no tempo.22

A lógica fundamental do STI é a “interrupção”. O pesquisador coleta uma longa série de observações de um desfecho de interesse em intervalos regulares (ex: taxas de mortalidade mensais, vendas trimestrais, notas anuais) antes da implementação da intervenção. Essa série de dados pré-intervenção é usada para estabelecer uma tendência de linha de base, ou seja, para entender o comportamento do desfecho ao longo do tempo na ausência da intervenção. A intervenção, quando implementada, “interrompe” essa série temporal. O efeito causal da intervenção é então inferido comparando-se o padrão da série no período pós-intervenção com o padrão que teria sido esperado se a tendência pré-intervenção tivesse continuado sem alterações.23

O verdadeiro poder do STI reside, portanto, na sua capacidade de criar seu próprio contrafactual. A série de dados pré-intervenção não serve apenas como uma linha de base estática; ela é usada para modelar e projetar o que teria acontecido com o desfecho se a intervenção nunca tivesse ocorrido. O efeito causal é a diferença entre o que realmente aconteceu (a série observada pós-intervenção) e esse contrafactual projetado. Essa abordagem permite detectar dois tipos principais de efeitos:

- Mudança de Nível (Level Change): Um salto ou queda abrupta e imediata no valor do desfecho logo após a intervenção.

- Mudança de Tendência (Slope Change): Uma alteração na inclinação ou na trajetória da série temporal após a intervenção. O desfecho pode começar a crescer mais rápido, mais devagar, ou inverter sua direção.

Ao modelar a tendência subjacente, o delineamento STI controla inerentemente muitas ameaças à validade interna, como maturação (que apareceria como parte da tendência de longo prazo) e regressão à média. Se uma mudança abrupta e sustentada no nível ou na tendência coincide precisamente com o momento da intervenção, torna-se menos plausível que seja resultado de processos graduais. Consequentemente, a principal ameaça à validade interna que permanece em um delineamento STI bem conduzido é a história: a possibilidade de que outro evento externo, que não a intervenção, tenha ocorrido exatamente no mesmo momento e causado a mudança observada.5

4.2 Estrutura de um Estudo de STI e Requisitos de Dados

A estrutura de um estudo STI é representada por uma sequência de observações ao longo do tempo, interrompida pela intervenção (X):

A validade e o poder estatístico de um delineamento STI dependem criticamente do número de pontos de dados disponíveis, tanto antes quanto depois da intervenção.5 Um número substancial de observações pré-intervenção (recomenda-se frequentemente um mínimo de 8 a 10 pontos) é essencial para modelar a tendência de linha de base de forma estável e confiável. Da mesma forma, múltiplas observações pós-intervenção são necessárias para determinar se o efeito da intervenção é transitório ou sustentado e para modelar a nova tendência.22 Dados coletados rotineiramente por agências governamentais ou instituições de saúde são frequentemente ideais para estudos STI, pois fornecem séries temporais longas e consistentes.24

4.3 Análise Estatística: Regressão Segmentada

A principal ferramenta analítica para estudos STI é a análise de regressão segmentada (segmented regression analysis).22 Este método estatístico modela a série temporal ajustando uma linha de regressão (ou segmento) para o período pré-intervenção e outra para o período pós-intervenção. O modelo de regressão inclui termos para estimar:

- O nível e a tendência da linha de base (pré-intervenção).

- A mudança imediata no nível no momento da intervenção.

- A mudança na tendência após a intervenção.

Uma consideração metodológica essencial na análise de séries temporais é a autocorrelação, que ocorre quando as observações em uma série não são independentes umas das outras (ex: o valor de hoje está correlacionado com o valor de ontem). A autocorrelação viola os pressupostos da regressão linear padrão e deve ser controlada com modelos estatísticos apropriados (como modelos ARIMA ou Prais-Winsten) para evitar conclusões espúrias.22 Além disso, a sazonalidade (padrões previsíveis e recorrentes, como o aumento de doenças respiratórias no inverno) também deve ser modelada e removida dos dados para que o efeito da intervenção possa ser isolado corretamente.26

4.4 Aplicações Práticas: Avaliação do Impacto de Políticas Públicas

O delineamento STI é excepcionalmente adequado para a epidemiologia e a avaliação de políticas de saúde. Um exemplo paradigmático no contexto brasileiro é a avaliação do impacto da Lei nº 11.705 de 2008, popularmente conhecida como “Lei Seca”, sobre as taxas de mortalidade por acidentes de trânsito.24 Pesquisadores utilizaram dados mensais de mortalidade por acidentes de trânsito de 2002 a 2015, totalizando 168 meses. A implementação da lei em meados de 2008 serviu como o ponto de interrupção. A análise de regressão segmentada permitiu estimar se houve uma queda imediata no nível da mortalidade e/ou uma mudança na tendência de longo prazo após a lei entrar em vigor, controlando pelas tendências pré-existentes. Este tipo de estudo fornece evidências robustas para os formuladores de políticas sobre a eficácia de intervenções em nível populacional.24 Outros estudos no Brasil têm usado o STI para avaliar tendências de mortalidade e incidência de diversas doenças, bem como o impacto de programas de vacinação e outras intervenções de saúde pública, demonstrando a ampla aplicabilidade e relevância do método.28

Capítulo 5: O Delineamento de Descontinuidade de Regressão (DDR)

5.1 O Princípio do Ponto de Corte (Cutoff): Explorando a Atribuição Baseada em Limiares

O Delineamento de Descontinuidade de Regressão (DDR), ou Regression Discontinuity Design (RDD), é um dos mais rigorosos e elegantes delineamentos quasi-experimentais. Sua aplicação é possível em cenários específicos onde a atribuição a um tratamento ou a elegibilidade para um programa é determinada por uma regra clara, baseada no fato de um indivíduo estar acima ou abaixo de um ponto de corte (cutoff) em uma variável contínua, conhecida como variável de atribuição ou forcing variable.30

A lógica do DDR pode ser ilustrada com exemplos práticos. Um programa de bolsas de mérito pode ser concedido a todos os estudantes que obtenham uma nota superior a 80 em um exame padronizado. Um benefício social pode ser destinado a famílias cuja renda per capita seja inferior a R$ 200 por mês. Um tratamento médico intensivo pode ser indicado para pacientes cujo escore de risco clínico ultrapasse um determinado limiar. Em todos esses casos, a variável contínua (nota do exame, renda, escore de risco) determina a participação no programa, e o valor específico (80, R$ 200, o limiar de risco) funciona como o ponto de corte que cria a descontinuidade.12

5.2 A Lógica da Comparabilidade Local: Por que o DDR se Aproxima de um Experimento Randomizado no Limiar

A genialidade do DDR reside em uma suposição poderosa: indivíduos que se encontram em uma vizinhança muito próxima do ponto de corte, mas em lados opostos, são, em média, extremamente semelhantes em todas as suas características, tanto observáveis (como demografia) quanto não observáveis (como motivação, habilidade inata). A ideia é que um estudante com nota 79.9 é, para todos os efeitos práticos, idêntico a um estudante com nota 80.1, exceto por um fato: o segundo recebe a bolsa de estudos e o primeiro não.12

Nessa janela infinitesimal ao redor do ponto de corte, a atribuição ao grupo de tratamento ou controle é “tão boa quanto aleatória”. O acaso ou a sorte de ter conseguido um décimo de ponto a mais determina a participação. Ao comparar os desfechos (ex: sucesso acadêmico futuro) desses dois grupos marginais, o DDR consegue isolar o efeito causal do tratamento de forma muito robusta, com uma validade interna que se aproxima da de um experimento randomizado.32 Esta comparação local, focada estritamente nos indivíduos ao redor do limiar, é o que confere ao DDR sua força para a inferência causal.

5.3 Tipos de DDR e Pressupostos

Existem duas variantes principais do DDR:

- DDR Nítido (Sharp RDD): A regra de atribuição é determinística e perfeitamente seguida. Todos os indivíduos de um lado do ponto de corte recebem o tratamento, e ninguém do outro lado o recebe. A elegibilidade se traduz perfeitamente em participação.

- DDR Difuso (Fuzzy RDD): A regra de atribuição não é perfeitamente seguida. Cruzar o ponto de corte não garante o tratamento, mas aumenta significativamente a probabilidade de recebê-lo. Por exemplo, ser elegível para um programa não significa que todos os elegíveis irão de fato se inscrever. O DDR difuso utiliza técnicas estatísticas mais complexas (como variáveis instrumentais) para estimar o efeito do tratamento.

A validade do DDR depende de pressupostos críticos que devem ser cuidadosamente avaliados. O primeiro é que a relação entre a variável de atribuição e a variável de desfecho deve ser contínua. A única “descontinuidade” ou “salto” nessa relação no ponto de corte deve ser causada pela intervenção. O segundo pressuposto fundamental é que os indivíduos não podem manipular de forma precisa e deliberada sua posição em relação ao ponto de corte. Se os estudantes, sabendo que o limiar é 80, conseguissem de alguma forma garantir que sua nota ficasse exatamente acima desse valor, isso introduziria um viés de seleção, pois os “manipuladores” podem ser sistematicamente diferentes dos não-manipuladores.33

Uma implicação importante da lógica do DDR é que ele não estima o efeito médio do tratamento para toda a população do estudo, mas sim o Efeito Médio Local do Tratamento (Local Average Treatment Effect – LATE). Ou seja, ele estima o efeito do tratamento especificamente para a subpopulação de indivíduos que estão na margem do ponto de corte. O efeito de uma bolsa de estudos para um aluno limítrofe (com nota 80.1) pode ser muito diferente do efeito para um aluno de alto desempenho (com nota 95). Isso significa que o DDR oferece uma estimativa com alta validade interna, mas sua validade externa (generalização) pode ser limitada à população marginal, uma nuance crucial na interpretação dos resultados.

5.4 Aplicações em Políticas Sociais

O DDR é uma ferramenta utilíssima para a avaliação de políticas sociais e de saúde que utilizam critérios de elegibilidade baseados em limiares. Um exemplo ilustrativo da aplicação do método no Brasil é um estudo que avaliou o impacto da aposentadoria por idade sobre a participação no mercado de trabalho.34 As regras da previdência social estabelecem idades mínimas para a aposentadoria (ex: 65 anos para homens urbanos). Essa idade funciona como um ponto de corte na variável contínua “idade”. O estudo demonstrou que, ao atingir a idade mínima, há um salto (uma descontinuidade) acentuado na probabilidade de um indivíduo estar aposentado. Aproveitando essa descontinuidade, os pesquisadores puderam estimar o efeito causal da aposentadoria sobre variáveis como a taxa de ocupação e as horas trabalhadas, comparando indivíduos que estavam imediatamente antes e depois da idade mínima. Este tipo de análise fornece evidências sobre os incentivos e os efeitos comportamentais das políticas de seguridade social.34

Capítulo 6: Estratégias Analíticas para Mitigação de Viés

A ausência de randomização nos estudos quasi-experimentais torna a fase de análise de dados particularmente crítica. Os pesquisadores devem empregar estratégias analíticas robustas para controlar os vieses, especialmente o viés de seleção, e fortalecer a inferência causal. Duas das técnicas mais poderosas e difundidas para este fim são a Análise de Diferença-em-Diferenças (DiD) e o Pareamento por Escore de Propensão (PSM).

6.1 Análise de Diferença-em-Diferenças (DiD)

A análise de Diferença-em-Diferenças (DiD ou Diff-in-Diff) é uma técnica estatística frequentemente utilizada em conjunto com o Delineamento com Grupo de Controle Não Equivalente (GCNE) com dados de pré e pós-teste.36 O seu objetivo é isolar o efeito de uma intervenção, removendo os vieses que podem surgir de tendências temporais e de diferenças fixas entre os grupos de tratamento e controle.36

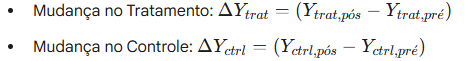

A lógica do DiD é baseada em uma dupla comparação, ou uma “dupla diferença”. O processo pode ser decomposto da seguinte forma 36:

- Primeira Diferença (Temporal): Para cada grupo (tratamento e controle), calcula-se a mudança no desfecho médio do período pré-intervenção para o período pós-intervenção. Essa diferença captura não apenas o possível efeito da intervenção (no grupo de tratamento), mas também todas as outras mudanças que ocorreram ao longo do tempo e que afetaram ambos os grupos (ex: inflação, mudanças sazonais, maturação).

- Segunda Diferença (Entre Grupos): A segunda diferença é calculada subtraindo-se a mudança observada no grupo de controle da mudança observada no grupo de tratamento. A mudança no grupo de controle serve como um contrafactual para a tendência temporal que o grupo de tratamento teria experimentado na ausência da intervenção.

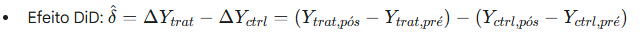

O resultado,

é o estimador de DiD do efeito da intervenção, que é “líquido” das tendências temporais comuns a ambos os grupos.

O pressuposto fundamental e não negociável para a validade da análise de DiD é o pressuposto das tendências paralelas (parallel trends assumption).39 Este pressuposto afirma que, na ausência da intervenção, a trajetória do desfecho no grupo de tratamento teria sido paralela à trajetória do desfecho no grupo de controle. Embora este pressuposto contrafactual não possa ser testado diretamente (pois não observamos o que teria acontecido com o grupo de tratamento sem a intervenção), sua plausibilidade pode ser fortemente apoiada. Se dados de múltiplos períodos pré-intervenção estiverem disponíveis, o pesquisador pode inspecionar visualmente e testar estatisticamente se as tendências dos dois grupos eram, de fato, paralelas antes da intervenção. Se as tendências divergiam antes do tratamento, o pressuposto é violado e as estimativas de DiD serão enviesadas.

6.2 Pareamento por Escore de Propensão (Propensity Score Matching – PSM)

O Pareamento por Escore de Propensão (PSM) é uma técnica estatística desenvolvida para mitigar o viés de seleção em estudos não-randomizados, criando um grupo de controle “artificial” que seja o mais semelhante possível ao grupo de tratamento com base em um conjunto de características observáveis.40

A lógica do PSM é construir um contrafactual para cada participante do grupo de tratamento. Para cada indivíduo tratado, o método busca encontrar um ou mais indivíduos não tratados que eram extremamente semelhantes antes da intervenção. Se o pareamento for bem-sucedido, a única diferença remanescente entre os grupos pareados será a exposição ao tratamento, mimetizando as condições de um experimento randomizado.43 Como parear indivíduos com base em um grande número de características simultaneamente é complexo, o PSM simplifica o problema utilizando o escore de propensão: a probabilidade condicional de um indivíduo receber o tratamento, dadas suas características pré-intervenção observadas.43

A implementação do PSM segue tipicamente os seguintes passos 41:

- Estimação do Escore de Propensão: Utiliza-se um modelo de regressão logística ou probit, onde a variável dependente é um indicador de participação no tratamento (1=tratado, 0=não tratado), e as variáveis independentes são um conjunto rico de características pré-tratamento que se acredita influenciarem tanto a seleção para o tratamento quanto o desfecho. O resultado do modelo para cada indivíduo é o seu escore de propensão, uma probabilidade que varia de 0 a 1.

- Pareamento (Matching): Após a estimação dos escores, um algoritmo de pareamento é aplicado para formar o grupo de controle. Existem vários algoritmos, cada um com seus trade-offs entre viés e eficiência:

- Vizinho Mais Próximo (Nearest Neighbor): Cada indivíduo tratado é pareado com o indivíduo não tratado que possui o escore de propensão mais próximo.

- Pareamento por Caliper ou Raio (Caliper/Radius Matching): Impõe uma tolerância máxima na diferença entre os escores de propensão para que um par seja considerado válido, melhorando a qualidade dos pares ao custo de descartar alguns indivíduos.

- Pareamento por Kernel (Kernel Matching): Utiliza uma média ponderada de todos os indivíduos não tratados para construir o contrafactual para cada indivíduo tratado, onde o peso é inversamente proporcional à distância entre os escores de propensão.

- Verificação de Balanceamento: Este é um passo crítico. Após o pareamento, o pesquisador deve verificar se o procedimento foi bem-sucedido em equilibrar as características observáveis entre os novos grupos de tratamento e controle. Isso é comumente feito comparando as médias das covariáveis e calculando a diferença padronizada de médias (Standardized Mean Difference – SMD), que deve ser idealmente inferior a 0.1 após o pareamento.43

A principal e intransponível limitação do PSM é que ele só pode controlar por fatores de confusão que são observados e incluídos no modelo de escore de propensão. Se existirem características não observáveis (como motivação, talento ou apoio familiar) que influenciam tanto a decisão de participar do tratamento quanto o desfecho, o PSM não conseguirá eliminá-las, e as estimativas do efeito do tratamento permanecerão enviesadas. Este pressuposto é conhecido como “independência condicional” ou “seleção nos observáveis”.40

DiD e PSM são ferramentas complementares. O PSM busca criar grupos que são equivalentes em nível no período pré-tratamento, enquanto o DiD assume que os grupos têm tendências paralelas, mesmo que seus níveis sejam diferentes. Em delineamentos avançados, as duas técnicas podem ser combinadas: pode-se primeiro usar o PSM para criar um grupo de controle mais equilibrado e, em seguida, aplicar a análise de DiD a essa amostra pareada para uma estimativa potencialmente mais robusta.

Capítulo 7: Conclusões e Recomendações Práticas

7.1 Síntese das Vantagens e Desvantagens dos Delineamentos Quasi-Experimentais

Os delineamentos quasi-experimentais ocupam um lugar indispensável no arsenal do pesquisador, oferecendo um caminho para a inferência causal em contextos onde os experimentos verdadeiros são impraticáveis. Sua força e suas limitações são duas faces da mesma moeda, originadas da ausência de randomização.

Vantagens:

- Viabilidade e Aplicabilidade: A principal vantagem é a sua aplicabilidade em cenários do mundo real. Eles permitem a avaliação de impacto de políticas, programas e eventos que, por sua natureza, não podem ser randomizados.19

- Validade Externa Elevada: Por serem conduzidos em ambientes naturalísticos e com populações que refletem os processos de seleção do mundo real, os resultados dos estudos quasi-experimentais tendem a ser mais generalizáveis do que os de ECRs altamente controlados e artificiais.5

- Considerações Éticas: Em muitas situações, negar uma intervenção potencialmente benéfica a um grupo de controle por meio da randomização seria eticamente questionável. Os quasi-experimentos contornam essa barreira ao aproveitar alocações que ocorrem naturalmente ou por critérios de necessidade.14

Desvantagens:

- Vulnerabilidade a Vieses: A ausência de randomização torna os estudos quasi-experimentais inerentemente mais vulneráveis a vieses, especialmente o viés de seleção. A possibilidade de que diferenças pré-existentes entre os grupos, e não a intervenção, expliquem os resultados é a principal ameaça à validade interna.5

- Validade Interna Reduzida: Comparados ao padrão-ouro dos ECRs, os quasi-experimentos possuem, por definição, uma validade interna mais baixa. As conclusões causais são, portanto, consideradas menos definitivas e mais dependentes de pressupostos teóricos e analíticos.5

- Complexidade Analítica: Para mitigar os vieses, os pesquisadores frequentemente precisam empregar técnicas estatísticas avançadas (como regressão segmentada, DiD, PSM), que exigem um maior nível de sofisticação metodológica e pressupostos que nem sempre são facilmente verificáveis.45

A qualidade e a credibilidade de um estudo quasi-experimental não residem, portanto, no delineamento em si, mas na transparência, no rigor e na honestidade intelectual com que o pesquisador aborda, testa e discute os pressupostos subjacentes e as limitações de seu estudo. Um bom estudo quasi-experimental não é aquele que alega ausência de viés, mas aquele que constrói um argumento cumulativo e convincente para a causalidade, demonstrando explicitamente que as principais ameaças à validade interna foram consideradas e, na medida do possível, neutralizadas.

7.2 Diretrizes para a Escolha do Delineamento Adequado

A escolha do delineamento quasi-experimental mais apropriado depende fundamentalmente da natureza da intervenção, da disponibilidade de dados e da pergunta de pesquisa específica. A tabela a seguir oferece um guia prático para auxiliar nessa decisão.

Tabela 3: Guia de Decisão para Escolha de Delineamentos Quasi-Experimentais

| Delineamento | Pergunta de Pesquisa Típica | Requisitos de Dados | Pressuposto-Chave | Principal Vantagem |

| GCNE com Pré/Pós-Teste | Qual o efeito de um programa piloto comparando uma escola que o recebeu com outra que não? | Dados de pré e pós-teste para um grupo de tratamento e um grupo de controle. | O viés de seleção pode ser adequadamente controlado ajustando-se pelas diferenças no pré-teste. | Flexível e amplamente aplicável quando grupos de comparação naturais existem. |

| Séries Temporais Interrompidas (STI) | Qual o impacto de uma nova lei nacional sobre as taxas de criminalidade? | Uma longa série temporal de dados (muitos pontos antes e depois) para a população-alvo. | Na ausência da intervenção, a tendência pré-existente teria continuado inalterada. | Forte validade interna para avaliar intervenções abruptas em nível populacional. |

| Descontinuidade de Regressão (DDR) | Qual o efeito de uma bolsa de estudos para os alunos que estavam no limiar de elegibilidade? | Variável de atribuição contínua com um ponto de corte claro; dados para indivíduos em ambos os lados do corte. | Indivíduos imediatamente acima e abaixo do ponto de corte são comparáveis em todas as outras características. | A mais alta validade interna entre os quasi-experimentos, aproximando-se de um ECR localmente. |

7.3 O Futuro dos Estudos Quasi-Experimentais

Na era da avaliação de políticas baseada em evidências e da crescente disponibilidade de big data administrativos, os estudos quasi-experimentais estão se tornando cada vez mais centrais. A capacidade de extrair inferências causais de dados não-experimentais é uma habilidade valorizada nos pesquisadores, gestores públicos e analistas de dados em diversos setores.

O futuro da metodologia quasi-experimental provavelmente verá uma integração ainda maior com técnicas de aprendizado de máquina (machine learning). Algoritmos podem ser usados para selecionar de forma mais sistemática o vasto número de covariáveis em modelos de escore de propensão, ou para modelar tendências contrafactuais mais complexas em estudos de séries temporais. No entanto, a tecnologia não substitui o rigor conceitual. A clareza sobre a pergunta de pesquisa, a compreensão profunda do contexto da intervenção e um ceticismo saudável em relação aos pressupostos metodológicos continuarão a ser as marcas de uma pesquisa quasi-experimental de alta qualidade.

Referências

- Hulley SB, Cummings SR, Browner WS, Grady DG, Newman TB. Delineando a pesquisa clínica. 4ª ed. Porto Alegre: Artmed; 2015.

- Maciejewski ML. Quasi-experimental design. Biostat Epidemiol. 2020;4(1):38-47.

- Gray JR, Grove SK, Sutherland S. Burns and Grove’s The Practice of Nursing Research: Appraisal, Synthesis, and Generation of Evidence. 9ª ed. St. Louis, MO: Elsevier; 2021.

- Harris AD, McGregor JC, Perencevich EN, Furuno JP, Zhu J, Peterson DE, et al. The use and interpretation of quasi-experimental studies in medical informatics. J Am Med Inform Assoc. 2006;13(1):16-23.

- Patino CM, Ferreira JC. Internal and external validity: can you apply this study to your patients? J Bras Pneumol. 2018;44(3):183.

- Campbell DT, Stanley JC. Experimental and Quasi-Experimental Designs for Research. Chicago: Rand McNally; 1963.

- Cook TD, Campbell DT. Quasi-experimentation: Design & analysis issues for field settings. Boston: Houghton Mifflin; 1979.

- Shadish WR, Cook TD, Campbell DT. Experimental and Quasi-Experimental Designs for Generalized Causal Inference. Boston: Houghton Mifflin; 2002.

- Bernal JL, Cummins S, Gasparrini A. Interrupted time series regression for the evaluation of public health interventions: a tutorial. Int J Epidemiol. 2017;46(1):348-355.

- Venkataramani AS, Bor J, Jena AB. Regression discontinuity designs in healthcare research. BMJ. 2016;352:i1216.

- Rosenbaum PR, Rubin DB. The central role of the propensity score in observational studies for causal effects. Biometrika. 1983;70(1):41-55.

- Caliendo M, Kopeinig S. Some practical guidance for the implementation of propensity score matching. J Econ Surv. 2008;22(1):31-72.

- Malta M, Cardoso LO, Bastos FI, Magnanini MMF, Silva CMFP. Iniciativa STROBE: subsídios para a comunicação de estudos observacionais. Rev Saude Publica. 2010;44(3):559-65.

- Andrade MV, Noronha K, Menezes RM, Souza MN, Guedes GR, Castro ALB, et al. O impacto da aposentadoria sobre o mercado de trabalho: uma análise a partir do delineamento de regressão descontínua. Brasília: Instituto de Pesquisa Econômica Aplicada (IPEA); 2016. (Texto para Discussão, No. 2229).

- Andreuccetti G, Carvalho HB, Cherpitel CJ, Ye Y, Ponce JC, Kahn T, et al. The Brazilian Law on Drinking and Driving: a quasi-experimental study of its impact on traffic accident related deaths. Addiction. 2011;106(11):1922-8.

- Lima-Costa MF, Barreto SM. Tipos de estudos epidemiológicos: conceitos básicos e aplicações na área do envelhecimento. Epidemiol Serv Saude. 2003;12(4):189-201.

- Antunes JLF, Cardoso MRA. Uso da análise de séries temporais em estudos epidemiológicos. Epidemiol Serv Saude. 2015;24(3):565-76.

- Dutra HS, Reis VN dos. Desenhos de estudos experimentais e quase-experimentais: definições e particularidades na pesquisa em enfermagem. Rev enferm UFPE on line. 2016;10(Supl. 5):4365-72.

- Selltiz C, Wrightsman LS, Cook SW. Research methods in social relations. 3ª ed. New York: Holt, Rinehart & Winston; 1976.

- Leal MC, Szwarcwald CL, Almeida PVB, Aquino EML, Barreto ML, Barros F, et al. Saúde reprodutiva, materna, neonatal e infantil nos 30 anos do Sistema Único de Saúde (SUS). Cien Saude Colet. 2018;23(6):1915-28.